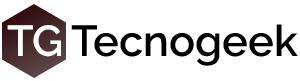

NVidia ha anunciado la NVidia H200, es una placa de video para procesar cosas, no para jugar, así como la H100 se utiliza normalmente para procesar y crear modelos de Inteligencia Artificial, la H200 viene a aumentar esas capacidades utilizando las memorias HBM3e que todavía ni siquiera están en el mercado.

La H200 no ofrecerá un GPU distinto sino mucha más memoria y más rápida, a razón de 141GB por placa contra los 80GB de las H100, es un salto importante que impacta directamente en todo el ambiente de desarrollo de AI.

El bus de memoria también crece de 5120 bits a 6144 bits llevando el ancho de banda a unos 4.8TB/segundo, utilizando el mismo GPU de la anterior, el GH100, por eso tal vez debería llamarse H101 o algo así, porque no han anunciado cambios más allá de la memoria.

Esto es confuso porque en Agosto ya habían hecho el anuncio formal del GPU GH200, así que llamar H200 a la placa que NO tendrá el GH200 sino un GH100 con más VRAM es… caótico como mínimo. Se ve como un stop-gap para rellenar un espacio que quedará huérfano en el medio entre el GH100 y el GH200 para aquellos que no puedan pagarlo, en resumen, una GH100 con la parte de memoria del GH200 que todavía tampoco veremos en acción hasta mediados de 2024.

Cuestión de memoria

Cuestión de memoria

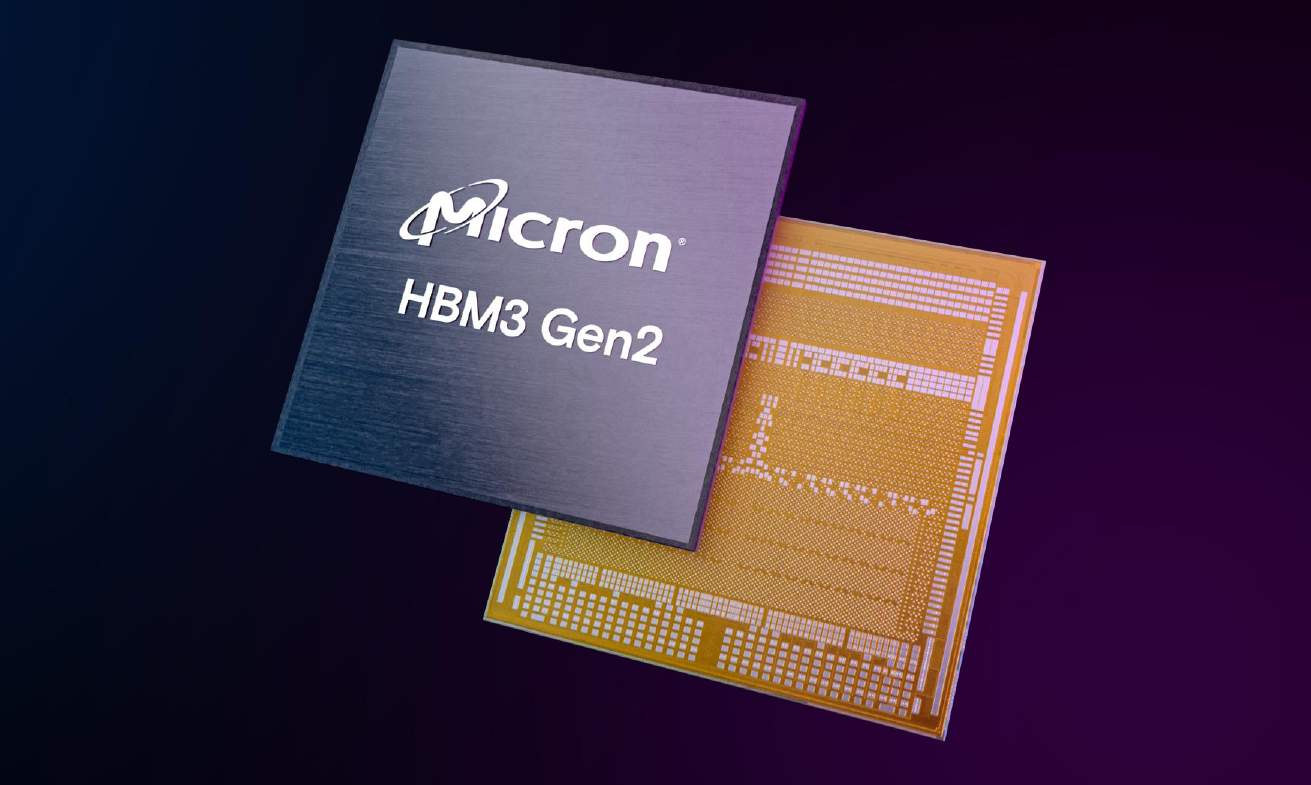

Las memorias son de Micron que, según sus especificaciones, saben que las memorias HBM3e pueden dar más ancho de banda todavía así que NVidia está siendo conservadora, pero considerando que combinaron dos modelos es algo entendible.

El número 141GB suena raro, en realidad físicamente hay 144GB, seis stacks de 24GB, NVidia se deja esos 3GB reservados por lo que es probable que, en pos de abaratar el costo de la H200, usen chips no perfectos de memoria, algo que la industria hace muy seguido, y puedan ofrecer esta placa a precios más razonables que la H100 original o, al menos, con mayores márgenes para la compañía.

A los servidores

De la mano de este “nuevo” GPU viene la plataforma HGX H200, que es la misma que la 100 pero con esta placa aceleradora, el tamaño y configuración es similar a la del HGX 100 por lo que los OEMs van a poder integrarlo sin inconvenientes en las plataformas existentes.

Todo esto antes de que, como dije, llegue el GH200 al mercado el cual hasta tendrá una nueva placa cuádruple:

288 núcleos ARM, 2.3TB de memoria, una bestia en una sola placa, al parecer con HMB3 en vez de HMB3e (por costos?) que combina el uso de HMB3 con LPDDR5X y que será parte de la supercomputadora Jupiter que ya mencionamos en octubre pasado.

288 núcleos ARM, 2.3TB de memoria, una bestia en una sola placa, al parecer con HMB3 en vez de HMB3e (por costos?) que combina el uso de HMB3 con LPDDR5X y que será parte de la supercomputadora Jupiter que ya mencionamos en octubre pasado.