Amazon es otra de las empresas que está creando sus propios procesadores como el Trainium2 presentado esta semana. Es un nuevo acelerador para cargas de trabajo de inteligencia artificial (IA) que aumenta tangiblemente el rendimiento en comparación con su predecesor, permitiendo a AWS entrenar modelos fundacionales (FM) y modelos de lenguaje grande (LLM) con hasta billones de parámetros. Además, AWS se ha fijado el ambicioso objetivo de permitir a sus clientes acceder a un rendimiento masivo de 65 ExaFLOPS ‘AI’ para sus cargas de trabajo.

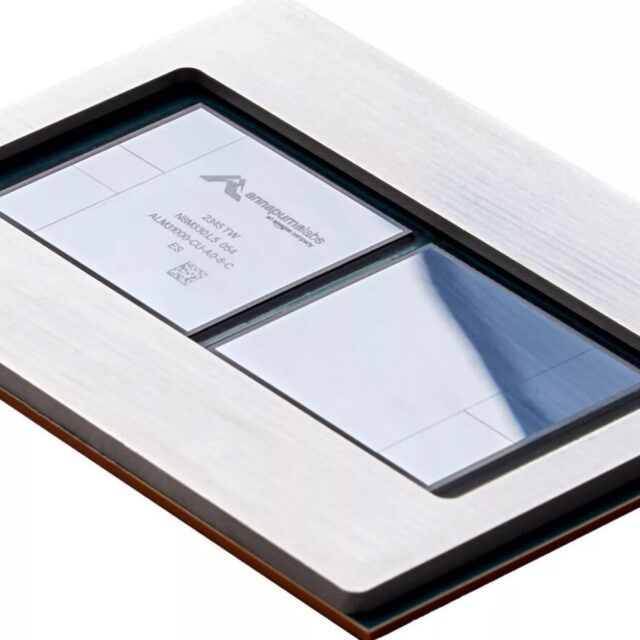

AWS Trainium2 es el acelerador de segunda generación de Amazon diseñado específicamente para el entrenamiento de FM y LLM. En comparación con su predecesor, el Trainium original, presenta un rendimiento de entrenamiento cuatro veces mayor, un rendimiento por watt dos veces mayor y una memoria tres veces mayor, para un total de 96 GB de HBM. El chip diseñado por el Annapurna Labs de Amazon es un sistema en paquete de múltiples chiplets que incluye dos bloques de cómputo, cuatro pilas de memoria HBM y dos chiplets cuyo propósito no se revela por ahora.

En particular, Amazon no revela cifras de rendimiento específicas de su Trainium2, pero dice que sus instancias Trn2 se escalan horizontalmente con hasta 100.000 chips Trainium2 para obtener hasta 65 ExaFLOPS de rendimiento informático de baja precisión para cargas de trabajo de IA. Lo cual, comparand hacia atrás, colocaría un solo acelerador Trainium2 en aproximadamente 650 TFLOPS. 65 EFLOPS es un nivel que solo se podrá alcanzar en las próximas supercomputadoras de IA de mayor rendimiento, como la Júpiter. Según AWS, tal escalamiento debería reducir drásticamente el tiempo de entrenamiento para un modelo de lenguaje grande de 300 mil millones de parámetros de meses a semanas.

Amazon aún tiene que revelar las especificaciones completas de Trainium2, pero nos sorprendería que no agregara algunas características además de las que el Trainium original ya admite. Como recordatorio, ese coprocesador admite formatos de datos FP32, TF32, BF16, FP16, UINT8 y FP8 configurables, además de ofrecer hasta 190 TFLOPS de rendimiento informático FP16/BF16.

Lo que quizás sea más importante que las cifras puras de rendimiento de un solo acelerador AWS Trainium2 es que Amazon tiene socios, como Anthropic, que están listos para implementarlo.

“Estamos trabajando estrechamente con AWS para desarrollar nuestros futuros modelos básicos utilizando chips Trainium”, dijo Tom Brown, cofundador de Anthropic. “Trainium2 nos ayudará a construir y entrenar modelos a muy gran escala, y esperamos que sea al menos 4 veces más rápido que los chips Trainium de primera generación para algunas de nuestras cargas de trabajo clave. Nuestra colaboración con AWS ayudará a organizaciones de todos los tamaños a desbloquear nuevas posibilidades. , ya que utilizan los sistemas de inteligencia artificial de última generación de Anthropic junto con la tecnología de nube segura y confiable de AWS”.

Via AWS